/ 목차 /

- Linux의 Ollama 설치 방법

- CUDA 드라이버 설치

- ollama 모델 다운로드

- ollama 모델 삭제

- ollama 모델 리스트 조회

- ollama 서비스 실행

- ollama 설치한 모델 실행

- ollama 자동실행 명령어

- ollama 시작 명령어

- ollama 중지 명령어

- ollama 리로드 명령어

- 로그 보기 명령어

- 업데이트 명령어

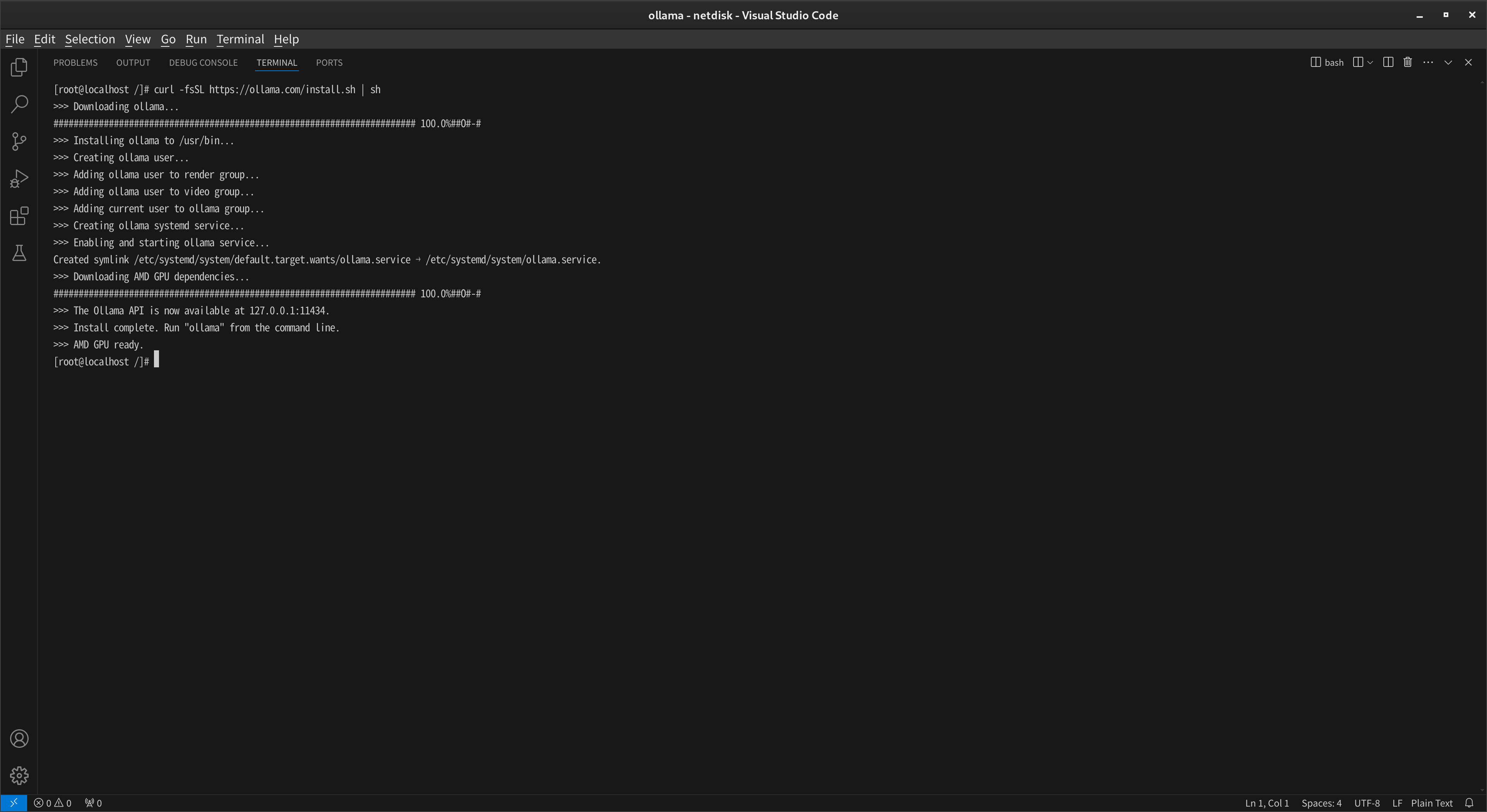

Linux의 Ollama 설치 방법

command curl -fsSL https://ollama.com/install.sh | sh

CUDA 드라이버 설치

- 선택 사항 – Nvidia GPU용 다운로드 주소 : https://developer.nvidia.com/cuda-downloads Nvidia GPU용 CUDA를 다운로드하기 위해 Nvidia의 다운로드 페이지에 접속하세요. 선택한 운영 체제와 CUDA Toolkit 버전에 맞게 다운로드한 후, 설치 가이드를 따릅니다. 추가적인 지원이 필요한 경우 Nvidia의 개발자 지원 페이지를 참고하세요.command nvidia-smiNvidia GPU를 사용하는 경우에는 CUDA를 설치하여 GPU를 활용할 수 있습니다. CUDA는 GPU를 사용하여 데이터를 처리하고 계산하는 데 사용되는 플랫폼입니다. 이를 통해 Ollama API를 호출할 때 데이터를 GPU에 올려 계산하고 처리한 후 더 빠르게 결과를 반환할 수 있습니다. CUDA 드라이버를 설치한 후에는 nvidia-smi 명령을 사용하여 GPU에 대한 세부 정보를 확인할 수 있습니다. 이를 통해 드라이버가 올바르게 설치되었는지 확인할 수 있습니다. 그러나 CUDA가 없는 경우에도 CPU를 사용하여 작업할 수 있지만, 이는 답변이 매우 느릴 수 있습니다. 따라서 CUDA를 활용하여 GPU를 활용하는 것이 빠른 결과를 얻는 데 도움이 될 것입니다.

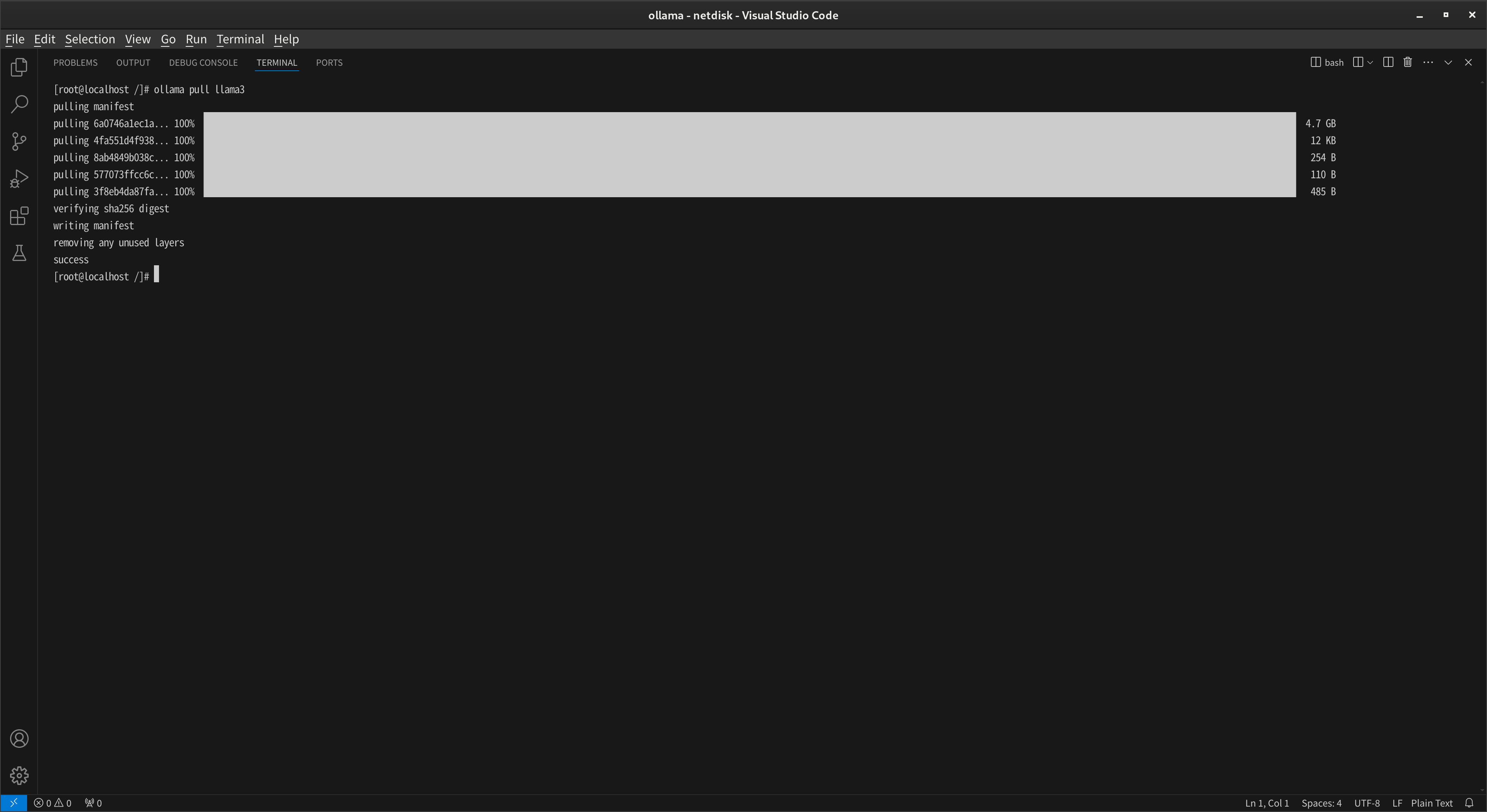

ollama 모델 다운로드

command ollama pull llama3

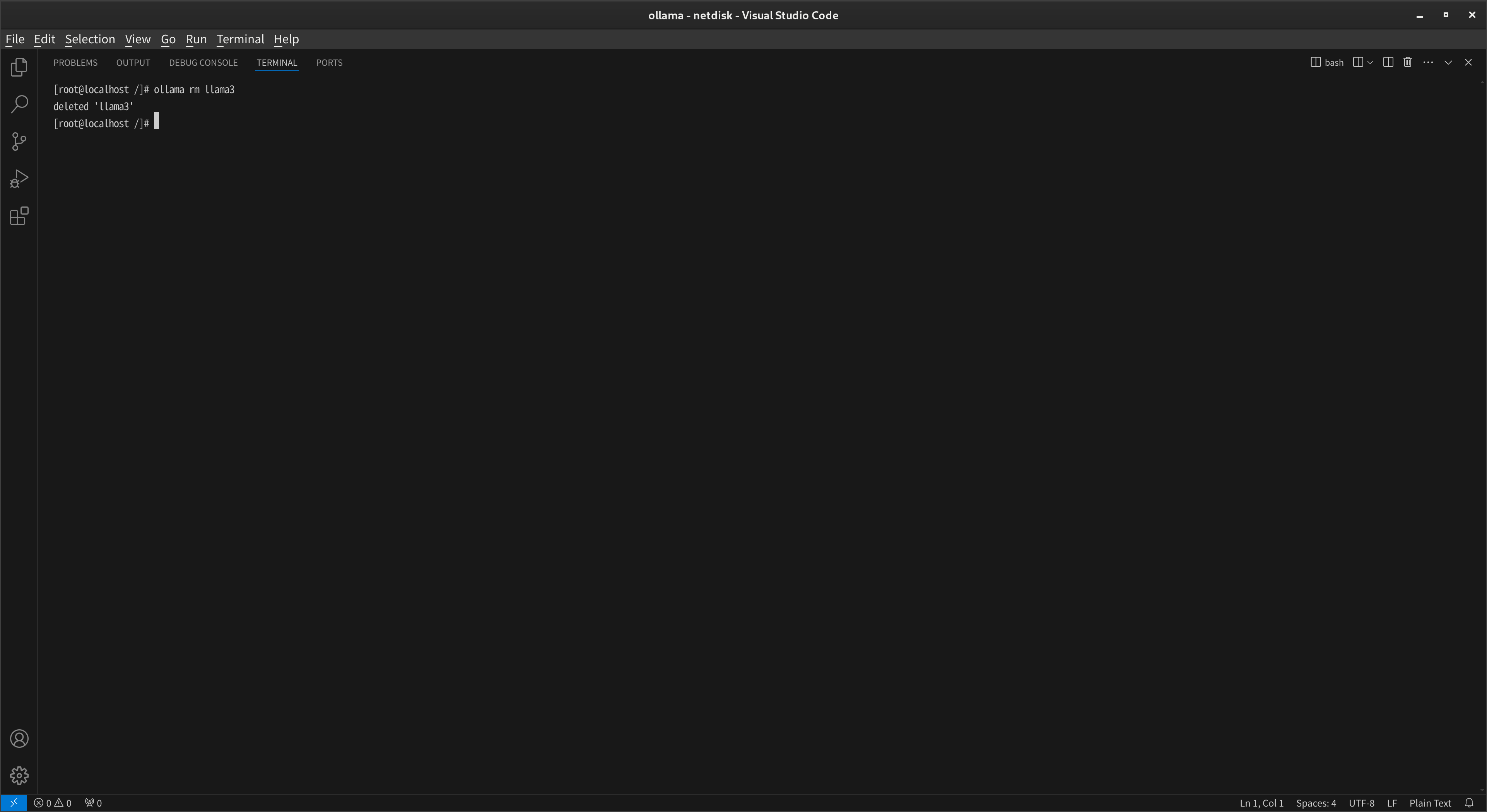

ollama 모델 삭제

command ollama rm llama3

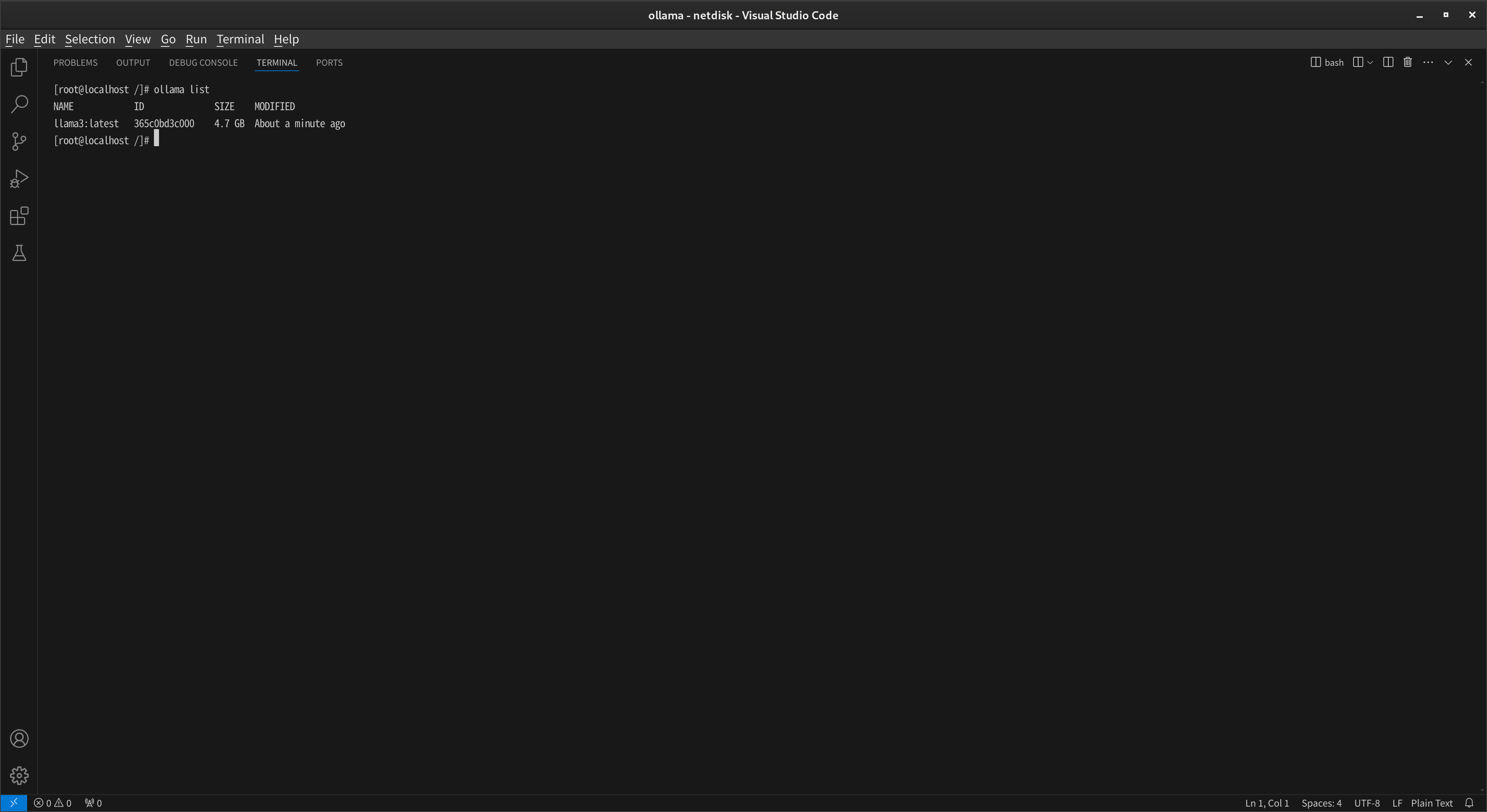

ollama 모델 리스트 조회

command ollama list

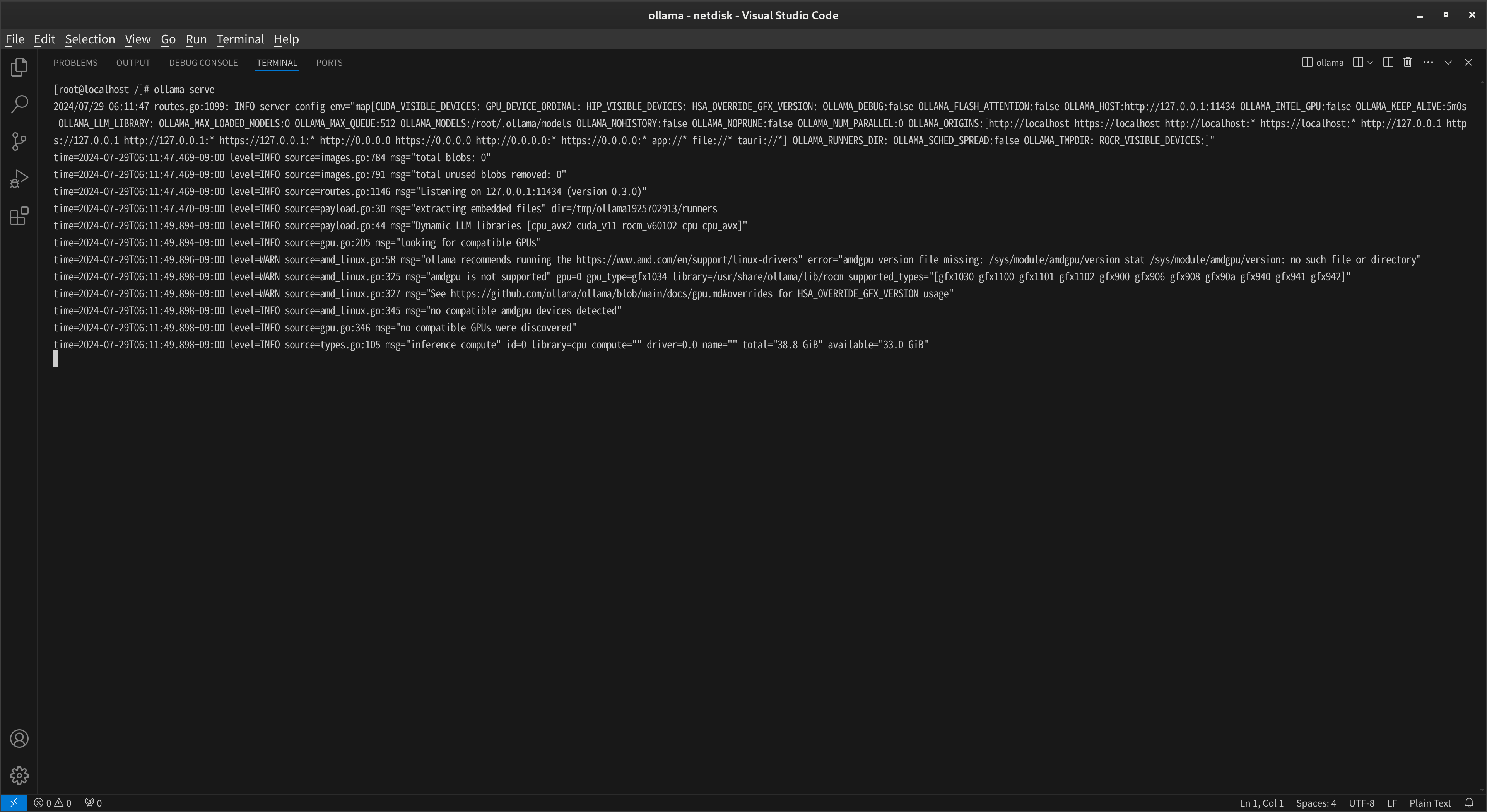

ollama 서비스 실행

command ollama serve

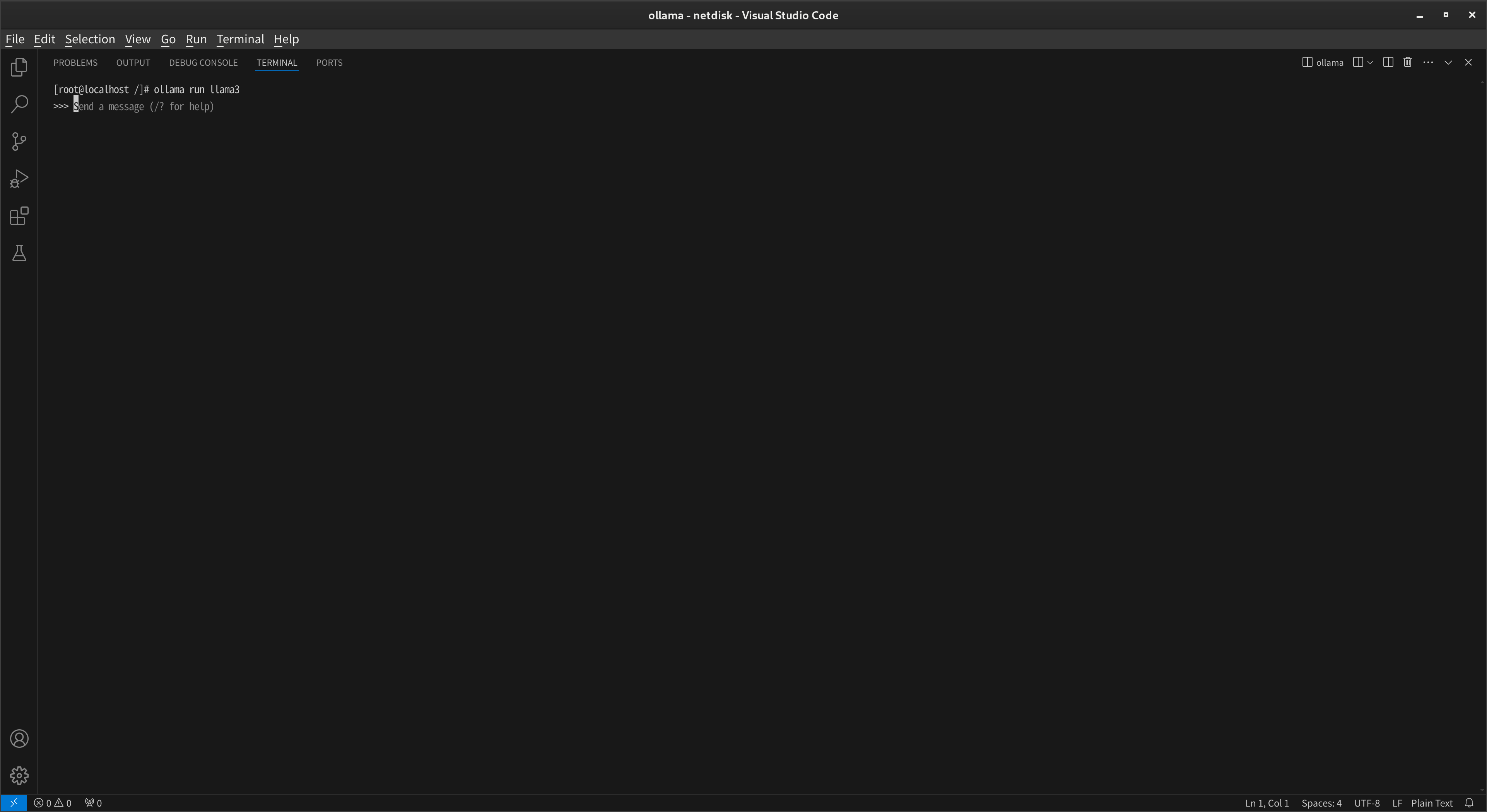

ollama 설치한 모델 실행

command ollama run llama3

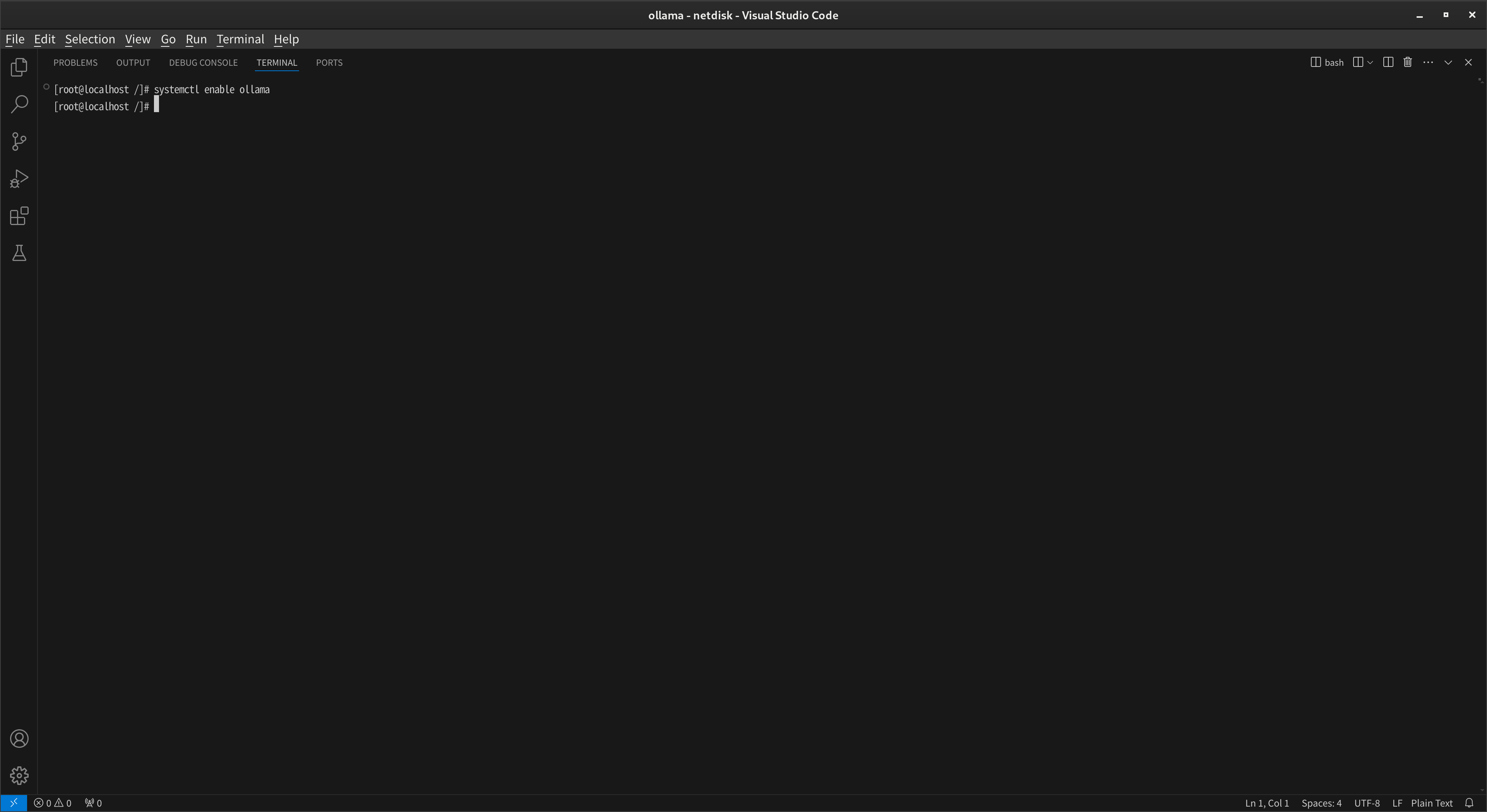

ollama 자동실행 명령어

command systemctl enable ollama

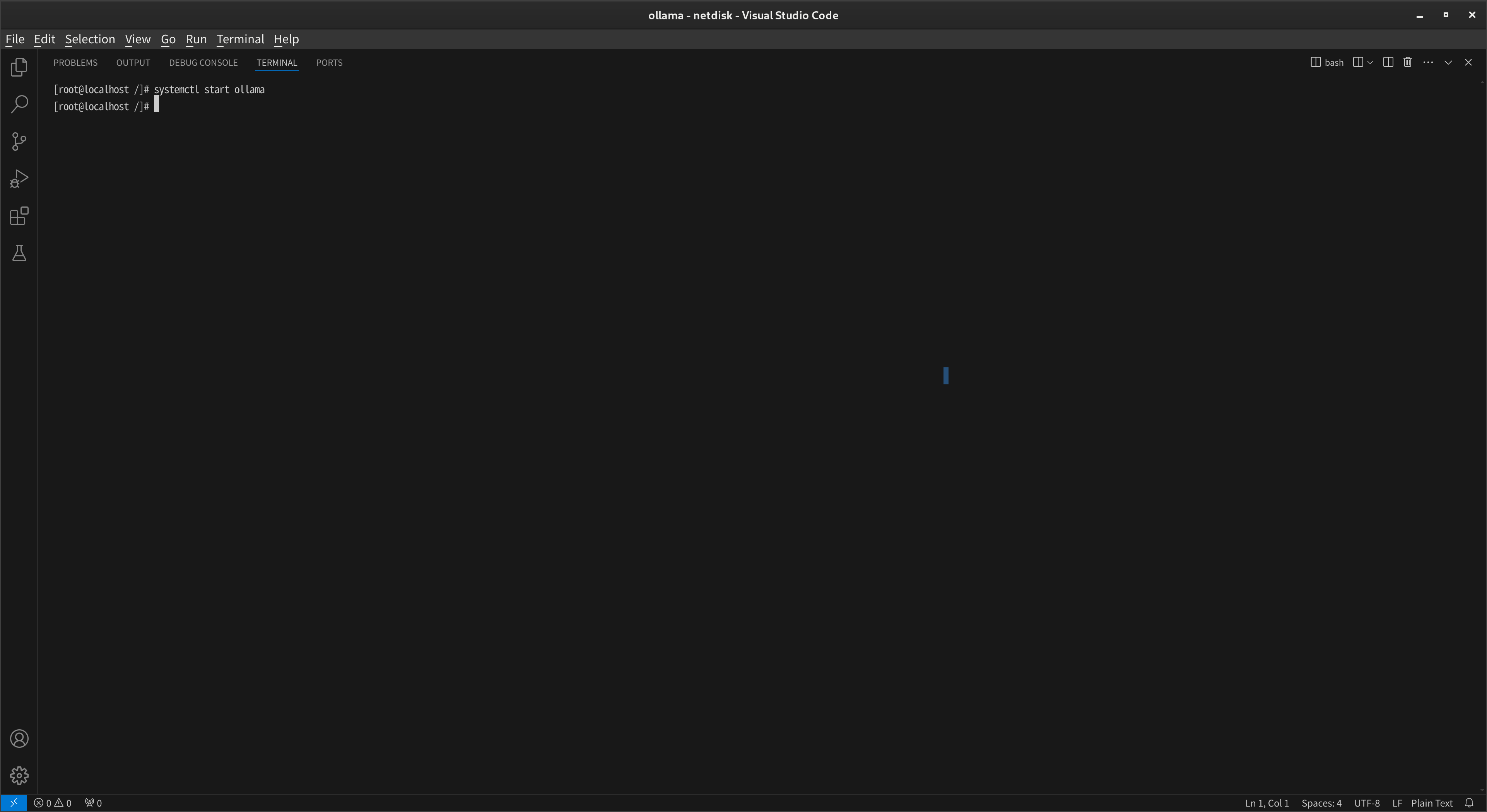

ollama 시작 명령어

command systemctl start ollama

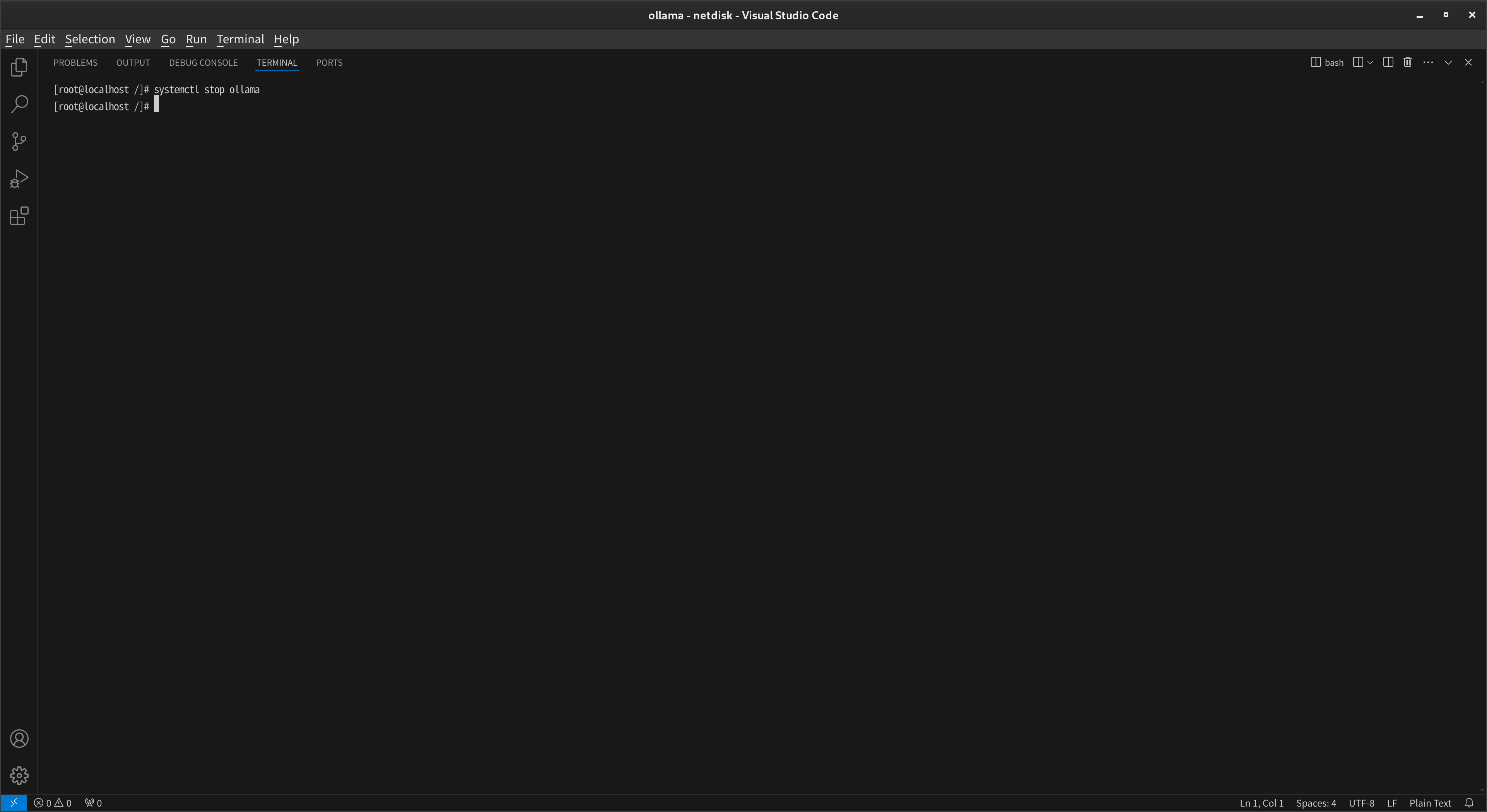

ollama 중지 명령어

command systemctl stop ollama

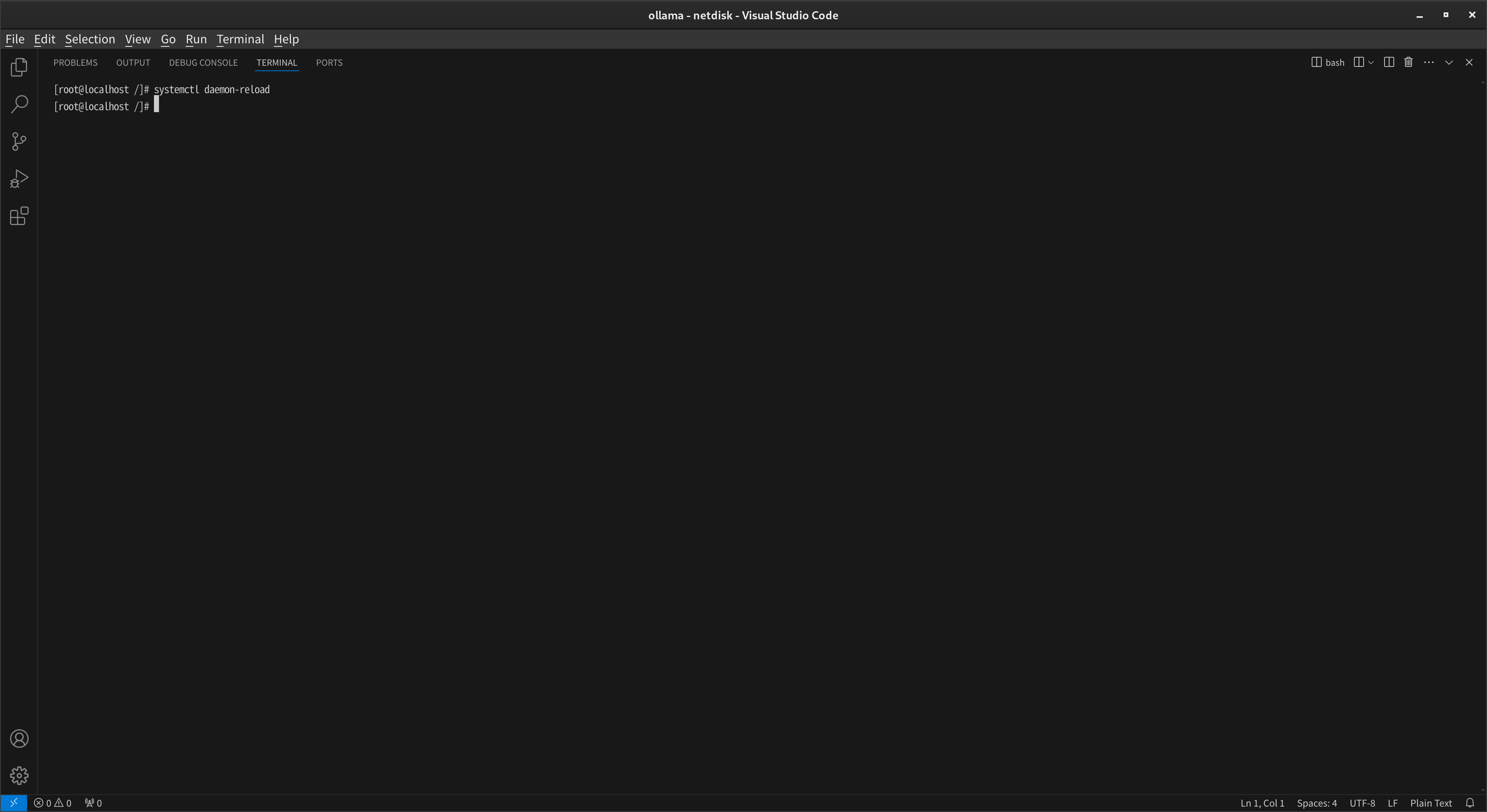

ollama 리로드 명령어

command systemctl daemon-reload

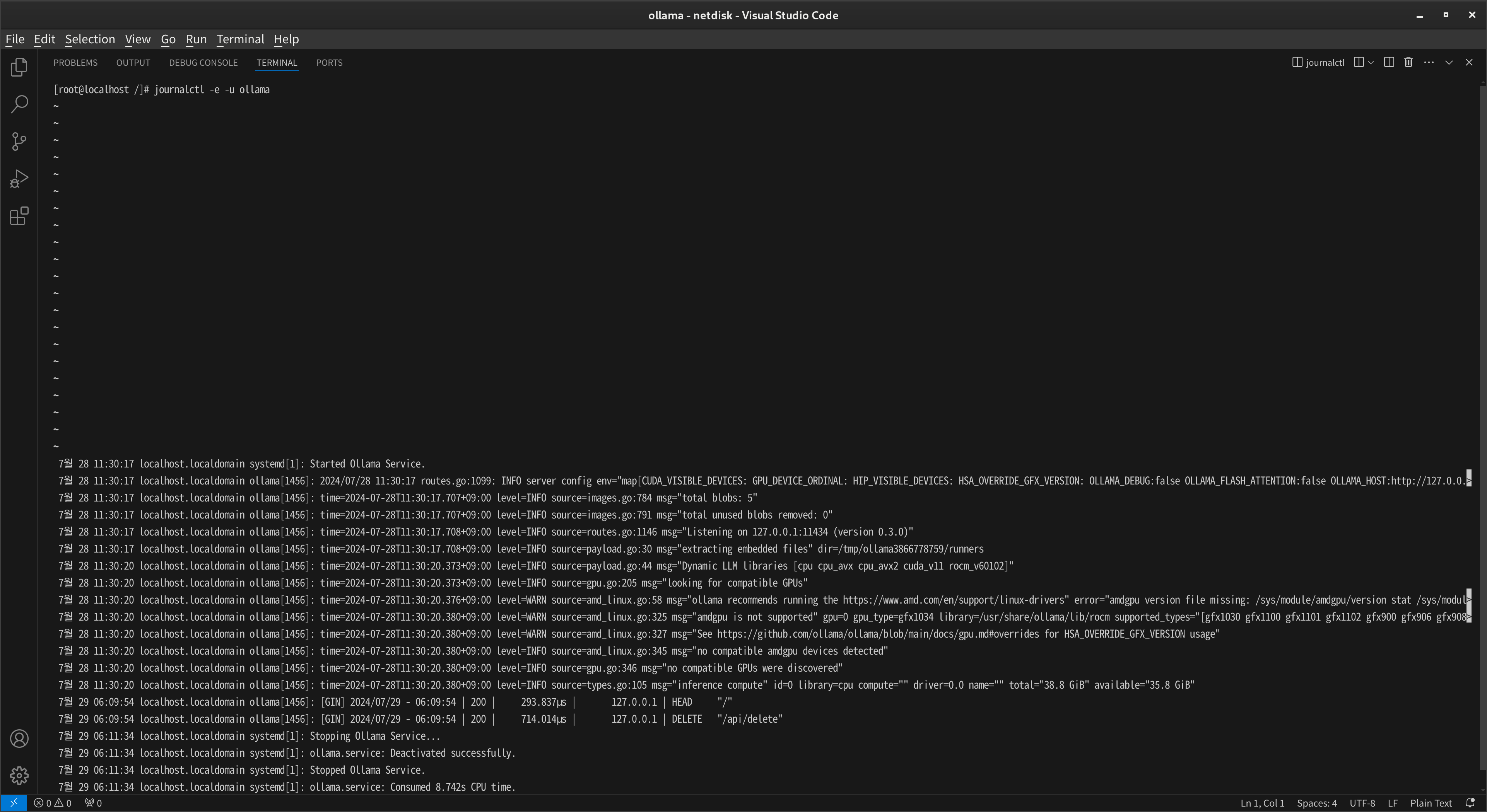

로그 보기 명령어

command journalctl -e -u ollama

업데이트 명령어

command curl -fsSL https://ollama.com/install.sh | sh

Comment